Data Engineer (DBT / Snowflake / Airflow / Python)

Role details

Job location

Tech stack

Job description

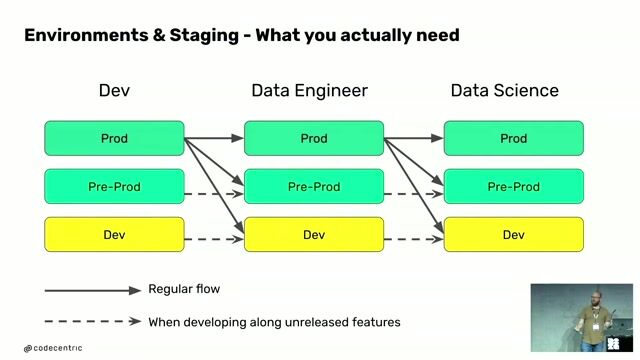

Dans un environnement data à forts enjeux de performance, de fiabilité et de conformité, vous intégrerez une équipe data encadrée par un Tech Lead Data. Vous interviendrez sur la conception, l?industrialisation et l?exploitation de pipelines de données au sein d?une plateforme cloud moderne.

Missions Principales :En tant que Data Engineer, vous serez en charge de : Concevoir et développer des pipelines de données robustes et scalables (ELT) ;

Intégrer les données issues de sources multiples dans Snowflake ;

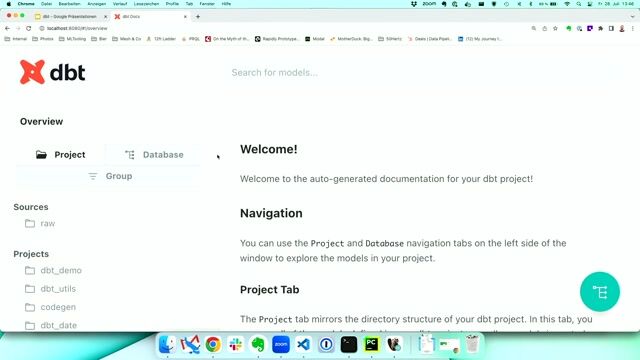

Développer et maintenir les modèles de données analytiques avec DBT (datamarts métiers, tests, documentation) ;

Orchestrer les traitements data via Apache Airflow (DAGs, scheduling, dépendances) ;

Optimiser les performances, la qualité et les coûts du Data Warehouse ;

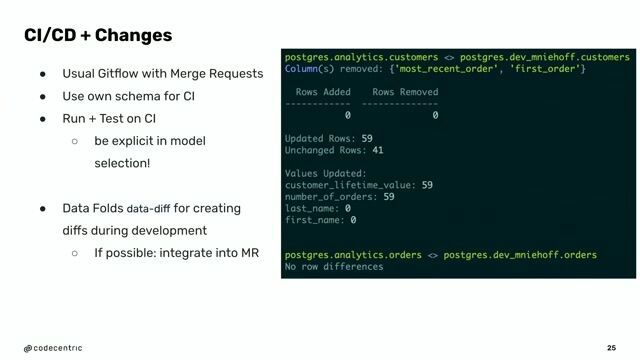

Industrialiser les flux data (automatisation, CI/CD, monitoring, reprise sur incident) ;

Participer à l?amélioration continue de la plateforme data et être force de proposition sur les choix techniques.

Requirements

Compétences Requises : Data Engineering & Analytics

Data Warehouse : Snowflake

Transformation des données : DBT

Orchestration : Apache Airflow

Langages : Python, SQL

Qualité & observabilité : Tests DBT, logs, monitoring (Splunk)

Benefits & conditions

Cloud & DevOps

Cloud : AWS (S3, Lambda, DynamoDB)

CI/CD & Versioning : GitLab CI

Infrastructure as Code : Terraform

Conteneurisation : Docker

APIs & intégration : Apigee

OS : Linux

Dataviz (en interaction avec les équipes BI)