Data Engineer (all genders)

DYMATRIX GmbH

2 days ago

Role details

Contract type

Permanent contract Employment type

Full-time (> 32 hours) Working hours

Regular working hours Languages

German Experience level

JuniorJob location

Tech stack

.NET

Artificial Intelligence

Data analysis

Confluence

JIRA

Azure

C Sharp (Programming Language)

Software as a Service

Cloud Computing

Data Transmissions

Information Engineering

ETL

Python

SQL Azure

Software Systems

SQL Databases

Data Processing

Azure

Data Lake

PySpark

Cosmos DB

Laptops

REST

Api Management

Serverless Computing

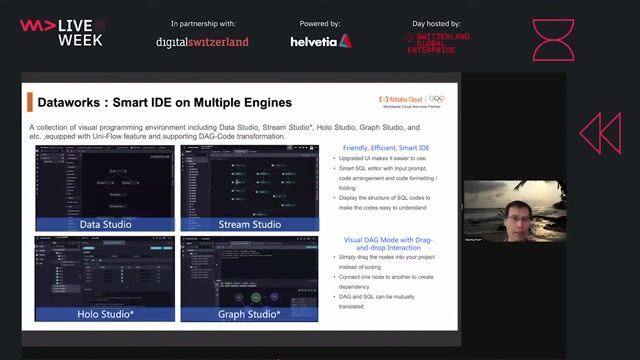

Databricks

Job description

In einem interdisziplinären Projektteam übernimmst Du den Part der technischen Umsetzung von Datenverarbeitungsstrecken in Batch und Realtime. Als Experte für das Data Engineering bist Du im Projekt Ansprechpartner für Kollegen und Kunden. Mit modernen cloud-basierten Technologien generierst Du - KI-unterstützt - innovative Lösungen rund um unsere Produkte., * Weitere Komponenten aus dem Azure Stack wie Log Analytics, KeyVault, API Management

- Azure Portal

- Unternehmenseigener OpenAI-basierter KI-Assistent

- Projektverwaltung in JIRA und Confluence, * Entwicklung von Azure Functions in .NET C# zur Abbildung von Datentransformationen in Realtime. REST API

- Erstellung und Pflege von Azure Data Factory Pipelines zur Automatisierung von Datentransfers.

- Entwicklung von Azure Databricks Notebooks, insbesondere zur Implementierung von ETL-Prozessen mit PySpark - dabei sind erste Programmierkenntnisse und ein gutes Verständnis für Datenverarbeitung gefragt.

- Arbeiten mit SQL, inklusive der Durchführung von Qualitätssicherungen, Datenanalysen und gezielten Performanceoptimierungen auf Speichertechnologien wie Cosmos DB, Azure SQL DB und Data Lake Storage

- Optimierung und Feintuning der Prozesse durch Detailanalysen u. a. mit Log Analytics

Requirements

Das bringst du idealerweise mit:

- Erste Kenntnisse Programmierkenntnisse (idealerweise in C#, Python und Pyspark).

- SQL-Kenntnisse zur Datenanalyse und Qualitätssicherung

- Verständnis für Cloud-Architekturen und Datenverarbeitungsprozesse

- Interesse an konzeptionellen Themen rund um Datenmodellierung und ETL-Design

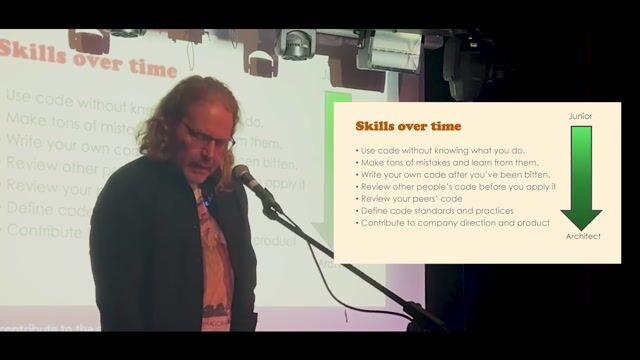

- Bereitschaft zur Weiterentwicklung in Technologien wie Databricks und Data Factory