DevOps Senior Kafka

Role details

Job location

Tech stack

Job description

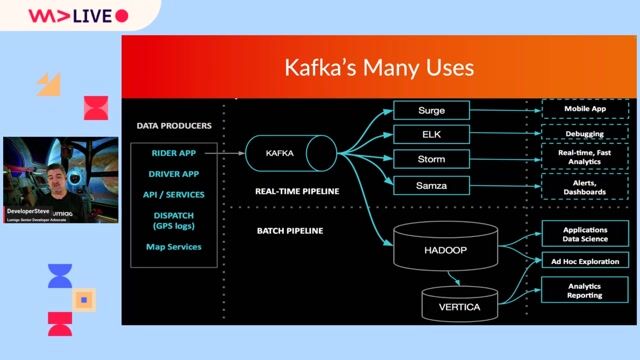

Intégré(e) dans les équipes Plateforme Data le/la consultant(e) aura pour mission de participer à la mise en place et à l'amélioration continue des pipelines de données en utilisant des technologies DevOps telles que Kafka, Kubernetes et GCP. Il/elle sera en charge de l'automatisation des déploiements, de la surveillance des performances et de la gestion des incidents.

Le/la consultant(e) travaillera en étroite collaboration avec les équipes de développement et d'infrastructure pour garantir la fiabilité et la scalabilité des plateformes de données.

Requirements

-

Maîtriser les technologies GCP (Google Cloud Platform) telles que Google Kubernetes Engine (GKE), Cloud Storage, Cloud SQL et Cloud Monitoring.

-

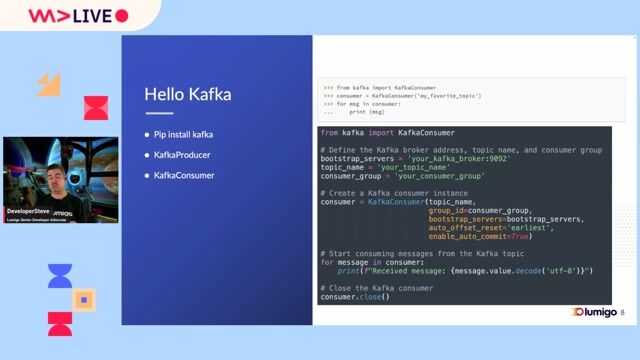

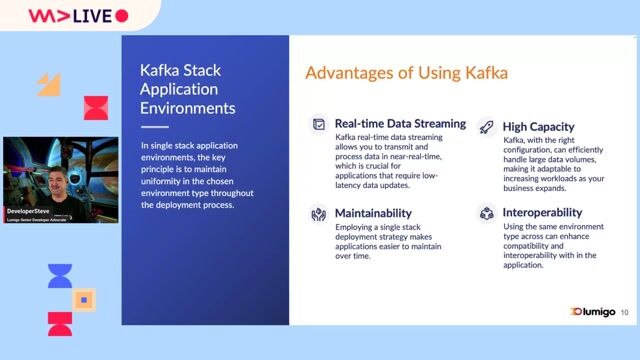

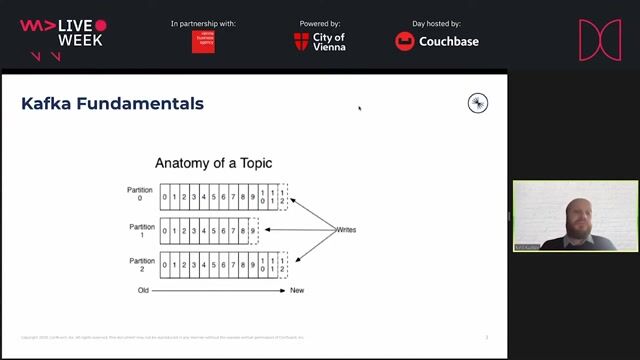

Posséder une expertise approfondie de Kafka, y compris sa configuration, sa gestion et son optimisation.

-

Avoir une solide expérience avec Kubernetes, notamment la création et la gestion de clusters, le déploiement d'applications et la supervision des performances.

-

Être à l'aise avec les concepts DevOps, tels que l'intégration continue (CI) et la livraison continue (CD), et les outils associés.

-

Connaissance des bonnes pratiques de sécurité et de la mise en place de politiques d'accès.

-

Compréhension des concepts de base des bases de données relationnelles.

-

Maîtrise des scripts de scripting (bash, Python, etc.).

-

Esprit d'analyse et d'amélioration continue : Capacité à évaluer le code et ses impacts, ainsi qu'à remettre en question les solutions existantes pour les améliorer.

-

Capacité à travailler de manière autonome et à gérer son temps efficacement.

-

Excellente communication écrite et orale : Aptitude à produire des livrables et des reportings de haute qualité.

-

Esprit d'équipe : Capacité à collaborer efficacement avec les membres de l'équipe pour atteindre des objectifs communs.

-

Maîtrise des concepts d?Agilité (Scrum, Sprint Planning, Backlog?).