Big Data Architect

Role details

Job location

Tech stack

Job description

1 week ago Be among the first 25 applicants rdia. ️ ¿Cómo será tu día o ¡Hola, Data Lover! ¿Te gustaría llevar tus habilidades de Data, BI, Analytics y Cloud al siguiente nivel? Descubre el poder de SDG: Líderes globales en Big Data, Business Intelligence, Análisis de Datos & Soluciones en la Nube Trabajamos con más de 70 clientes a nivel global, ofreciendo soluciones innovadoras en BI, Big Data, Cloud e IA. Con alianzas estratégicas con Microsoft, Google y AWS, contamos con las mejores herramientas y aceleradores tecnológicos para transformar grandes volúmenes de datos en soluciones de alto impacto. En SDG iLabs, impulsamos la innovación experimentando con las últimas tendencias en tecnologías de datos, llevando a nuestros clientes hacia el futuro del análisis de datos en la nube. Si te apasionan los datos y buscas estar a la vanguardia de la tecnología, ¡te estamos esperando! Forma parte de Data Technologies y trabaja junto a un equipo líder en especialización de datos, transformando datos en impacto real con proyectos innovadores y herramientas de vanguardia. ¿Cómo será tu día a día? 1. Desarrollarás soluciones de datos end-to-end, desde el entendimiento del problema hasta la puesta en producción. 2. Aportarás tu visión técnica en el diseño de arquitecturas y procesos, participando en debates y decisiones clave. 3. Definirás e implementarás estrategias de modelado y transformación de datos según las necesidades del proyecto. 4. Colaborarás en la toma de requerimientos para arquitecturas y pipelines de datos. 5. Probarás nuevas tecnologías y servicios cloud, aportando innovación a nuestros proyectos. ¿Qué te hará triunfar en esta posición? * Formación en Ingeniería Informática, Telecomunicaciones o titulaciones técnicas relacionadas con ingeniería del software. * Más de 4 años de experiencia como Data Engineer, desarrollando soluciones de ingesta y transformación de datos en entornos on-premises o cloud.

Requirements

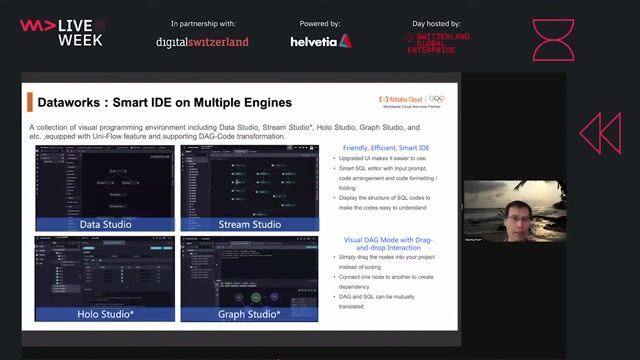

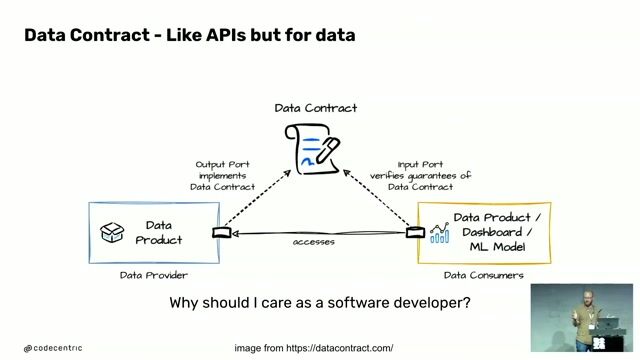

- Experiencia en arquitectura de datos, trabajando con estructuras, particionado, modelado y ciclo de vida en Data Lake. * Inglés para trabajar en un entorno global. Valora también: * Experiencia en plataformas modernas como Databricks, Dataproc o EMR; o en plataformas tradicionales como Cloudera o Stratio. * Procesos dirigidos por metadatos. * Integración de datos: frameworks de procesamiento Spark o Beam y lenguajes Python, Scala o Java. * Orquestación: experiencia con Apache Airflow o DataBricks Workflows. * Gestión del código: buenas prácticas y metodologías. * Familiaridad con conceptos como DataOps, Data Observability y Data Mesh. * Conocimiento en tecnologías como SQL, Snowflake, dbt, Azure Data Factory o Microsoft Fabric. * Experiencia con contenedores y orquestación. * Cloud & Automatización: infraestructura, pipelines de datos, operación y monitorización. * Experiencia en consultoría en Data & Analytics. *