Arquitecto/a Sistemas Big Data

Role details

Job location

Tech stack

Job description

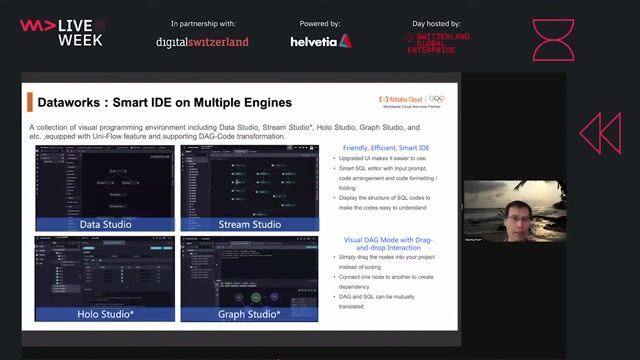

PUEDATA Madrid, Community of Madrid, Spain Job Description En PUEDATA buscamos un/a Arquitecto/a de Sistemas Big Data que quiera unirse a nuestro equipo para diseñar y liderar soluciones de datos a gran escala. Si te apasiona crear arquitecturas robustas, escalables y de alto rendimiento, este es tu lugar. ? ¿Qué harás en tu día a día? * Diseñar y documentar arquitecturas de datos de alto nivel, definiendo tecnologías, flujos e integraciones. * Evaluar y seleccionar herramientas Big Data (Hadoop, Spark, Kafka, etc.) según las necesidades de negocio. * Liderar la implementación junto a los equipos de desarrollo y operaciones. * Optimizar procesos de ingestión, almacenamiento, procesamiento y análisis de datos. * Identificar y resolver cuellos de botella de rendimiento. * Velar por la seguridad, calidad y privacidad de los datos. * Colaborar con áreas de negocio y desarrollo para traducir requisitos en soluciones escalables. * Dar soporte de nivel 3 en incidentes críticos de la plataforma. ¿Qué ofrecemos para que quieras venirte a PUEDATA? * Contrato indefinido. * Horario (flexible) de L a J de 9h a 18:30h y viernes de 8h a 15h. * 50% teletrabajo (el mes de agosto y navidad 100% teletrabajo) * 23 días de vacaciones. * Formación y certificaciones (¡equipo 100% certificado!). Beneficios Extra * Seguro médico + dental (50% subvencionado). * Retribución flexible (comida, transporte, guardería, descuentos). * Plan de carrera personalizado. * Regalo de cumpleaños ?. * Ambiente cercano y buen rollo: team buildings, afterworks, Navidad, etc. Perfil requerido Buen conocimiento de herramientas de monitorización y optimización de rendimiento (Prometheus, Grafana, etc.). Requirements * Formación: FPII ASIR o título universitario en Ingeniería Informática, Sistemas o un campo relacionado. * Experiencia: mínimo 5 años en diseño y arquitectura de sistemas Big Data. * Sólidos conocimientos de tecnologías de Big Data: Hadoop, Spark, Kafka, Hive, HBase, Flink, entre otras. * Experiencia en bases de datos relacionales y no relacionales (PostgreSQL, MySQL, Cassandra, MongoDB, etc.). * Conocimiento de lenguajes de programación como Python, Scala o Java. * Experiencia en entornos Cloud (AWS, Azure o GCP) y sus servicios de datos (por ejemplo: AWS EMR, Azure Synapse, GCP BigQuery). * Inglés imprescindible, nivel B2 o superior (trabajarás en entornos internacionales). Opciones / Plataformas con las que podrás trabajar (se valorará experiencia en una o varias) * Plataformas Big Data: Cloudera, Hortonworks, MapR. * Entornos de Data Lake y Lakehouse: Databricks, Snowflake, Delta Lake. * Sistemas de mensajería/streaming: Apache Kafka, Pulsar. * Orquestación y procesamiento: Apache Airflow, NiFi, Luigi. * Contenedores y orquestación: Docker, Kubernetes. Se Valorará Además * Certificaciones en cualquiera de las plataformas anteriores.

Requirements

- Experiencia en Data Governance, Data Security y DataOps. #J-18808-Ljbffr