Data Architect - AWS

BETWEEN TECHNOLOGY

Municipality of Madrid, Spain

7 days ago

Role details

Contract type

Permanent contract Employment type

Full-time (> 32 hours) Working hours

Regular working hours Languages

Spanish, English Experience level

SeniorJob location

Remote

Municipality of Madrid, Spain

Tech stack

Agile Methodologies

Airflow

Amazon Web Services (AWS)

Amazon Web Services (AWS)

Apache HTTP Server

Computer Engineering

Data Architecture

Data Infrastructure

Github

Python

SQL Databases

Datadog

PySpark

Data Management

Terraform

Docker

Job description

Estamos buscando un/a Data Engineer - AWS para ampliar uno de nuestros equipos en modalidad remoto., * Te integrarás en el equipo de Data Engineering para diseñar, construir y mantener sistemas de gestión de datos que soporten la infraestructura de datos de nuestra empresa. Tus funciones específicas incluirán:

- Diseñar, documentar e implementar modelos de datos robustos (conceptuales, lógicos y físicos) para una plataforma Data Lakehouse sobre AWS.

- Liderar el desarrollo y la optimización de pipelines de datos escalables orientados a casos de uso analíticos complejos.

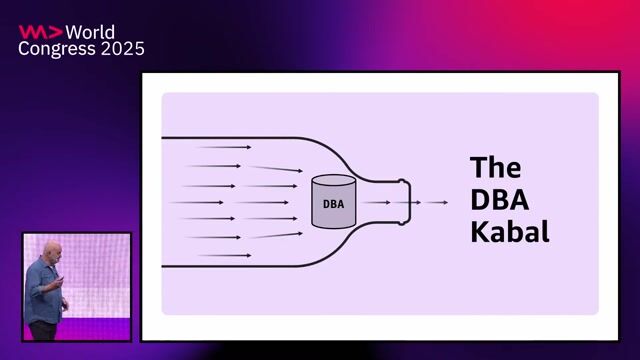

- Participar en decisiones arquitectónicas y en la definición de estándares de modelado de datos para toda la región.

- Trabajar estrechamente con equipos globales y locales para asegurar alineación y reutilización de componentes de datos.

- Aplicar prácticas modernas de infraestructura como código y despliegue automatizado para soluciones de datos.

- Asegurar la calidad, trazabilidad y gobierno del dato en toda la cadena.

- Actuar como referente técnico dentro del equipo europeo de Data Engineering.

Requirements

- Formación en Ingeniería Informática, Data Engineering o Data Scientist, o formaciones equivalentes

- +5 años de experiencia en Data Enginering, con enfoque profundo en modelado de datos.

- Dominio avanzado de AWS y experiencia práctica en servicios como S3, Glue, Redshift, Athena, Lake Formation, etc.

- Experiencia en diseño e implementación de Data Lakehouse en entornos productivos.

- Experiencia con SQL y herramientas como dbt, PySpark o equivalentes.

- Experiencia con Python para procesamiento y automatización.

- Experiencia con Apache Iceberg o tecnologías similares de formatos abiertos.

- Conocimientos en orquestación de workflows con Airflow.

- Dominio de prácticas de infraestructura como código con Terraform, y despliegue automatizado con GitHub Actions.

- Inglés profesional fluido (oral y escrito).

- Capacidad demostrada para colaborar en entornos distribuidos y multiculturales bajo metodologías ágiles.

- Inglés avanzado a nivel oral para reuniones., * Certificaciones oficiales de AWS en analítica o arquitectura.

- Conocimiento de frameworks de calidad de datos como Great Expectations.

- Experiencia en monitoreo y trazabilidad con herramientas como Datadog.

- Familiaridad con entornos locales basados en Docker.

- Experiencia en diseño y construcción de data products orientados a negocio.

- Capacidad para establecer estándares de modelado reutilizables y escalables a nivel regional., * Oportunidades de formación: Idiomas, Certificaciones, Bootcamps y mucho más.

- Multitud de eventos.

- Retribución flexible (restaurant, transporte, guardería y seguro médico).

Benefits & conditions

- Trabajo en remoto des de cualquier ubicación en España (se requiere de nacionalidad española o permiso de trabajo a 40h en España).

- Horario flexible y conciliación personal y familiar.

- Trabajarás en un ambiente dinámico con profesionales excelentes.

About the company

Damos soporte en una gran variedad de áreas como Firmware, Software, BI, Diseño, Project Management y muchas más. Además, desarrollamos soluciones tecnológicas a medida desde nuestros BETWEEN Labs.