Data Architect - Realtime Data & Infrastructure (Junior / Senior) 98% remote ID02242

Role details

Job location

Tech stack

Job description

Im Rahmen der Digitalisierungsplattform DataNet wird ein Team aus Junior- und Senior-Data Architects aufgebaut. Ziel ist die Entwicklung einer skalierbaren Realtime-Datenarchitektur, die Datenintegration, -verarbeitung und -analyse für datengetriebene Infrastruktur- und Machine-Learning-Projekte ermöglicht. Die Plattform unterstützt Fachbereiche bei der Bereitstellung, Visualisierung und Nutzung großer Datenmengen aus Bau-, Geo- und Fernerkundungsdaten., Konzeption und Weiterentwicklung von Daten- und Analytics-Architekturen für Infrastrukturprojekte

- Entwicklung von Datenmodellen, Datenbanken und ETL-Prozessen (Batch & Realtime)

- Definition und Implementierung von Standards für Datenqualität, Sicherheit und Governance

- Evaluation und Integration geeigneter Tools und Technologien (z. B. Spark, Azure, Directus)

- Zusammenarbeit mit Fachbereichen, Data Scientists und Entwicklern in agilen Teams

- Nutzung von Jira, Confluence, SharePoint und Directus für Dokumentation und Aufgabensteuerung, Hinweis: Die Rollen werden abgestuft besetzt: Der Senior Data Architect übernimmt die technische Leitung, Architekturplanung und Abstimmung mit Stakeholdern; der Junior Data Architect unterstützt bei Modellierung, Dokumentation und operativer Umsetzung.

Requirements

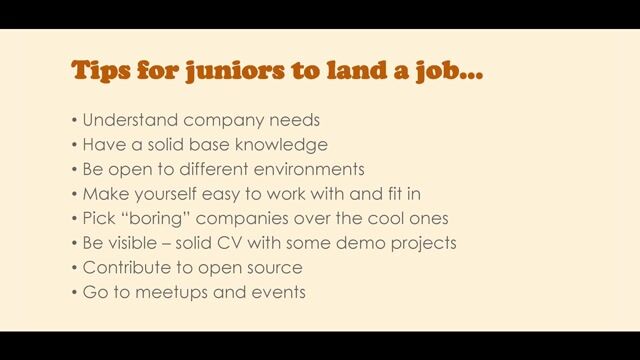

Anforderungen (Muss-Kriterien):

-

Erfahrung in der Arbeit mit großen Datenmengen (z. B. Spark, Big Data, Realtime-Processing)

-

Nachweisbare Kenntnisse in Cloud-Architekturen (z. B. Azure, AWS, GCP)

-

Erfahrung in der Entwicklung und Umsetzung von Datenarchitekturen oder -modellen

-

Kenntnisse in Data Science, Machine Learning oder KI im Umfeld großer Infrastrukturdaten

-

Erfahrung im Umgang mit Jira, Confluence und SharePoint

-

Gute Deutschkenntnisse (mind. B2-Niveau) Wünschenswert (Soll-Kriterien):

-

Erfahrung in der architekturellen oder strategischen Beratung datengetriebener Projekte

-

Kenntnisse in Statistik sowie in strukturierten und unstrukturierten Daten (z. B. Geodaten, Punktwolken, Fernerkundung)

-

Erfahrung in der Nutzung von agilen Methoden (Scrum, SAFe)

-

Zertifizierung im Bereich Data Engineering, Data Architecture oder Cloud