Data Engineer (DBT, Snowflake, BigQuery)

Role details

Job location

Tech stack

Job description

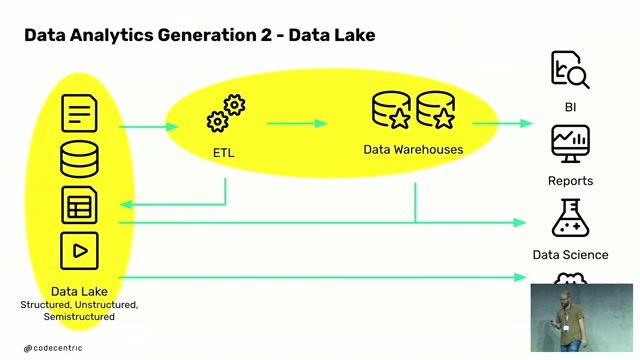

Desarrollarás y optimizarás procesos de ETL y ELT dirigidos por metadatos, utilizando herramientas como dbt, Informatica o Talend, para transformar grandes volúmenes de datos brutos en estructuras analíticas dentro de data warehouses como Snowflake, BigQuery o Redshift, garantizando eficiencia, trazabilidad y calidad en todo el ciclo de vida del dato.

Contribuirás con tu experiencia técnica al diseño de arquitecturas y flujos de datos, participando activamente en decisiones estratégicas y discusiones clave.

Diseñaras e implementarás modelos y procesos de transformación de datos adaptados a los objetivos del proyecto.

Participarás en la recopilación de requerimientos técnicos relacionados con arquitecturas y pipelines de datos.

Explorarás nuevas herramientas y tecnologías en la nube, aportando ideas innovadoras a los proyectos en los que participes., Aprenderás de lxs mejores. Te codearás con cracks del sector (tanto técnicos como de negocio), que estarán encantadxs de compartir su conocimiento y celebrar tu crecimiento.

Requirements

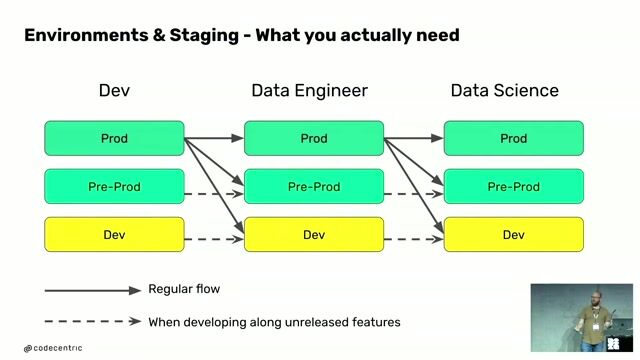

Formación en Ingeniería Informática, Telecomunicaciones o cualquier titulación técnica relacionada con la ingeniería del software. +4 años de experiencia como Data Engineer, desarrollando soluciones de ingesta y transformación de datos en entornos on-premise o cloud. Experiencia en arquitectura de datos, trabajando con estructuras, particionado, modelado y ciclo de vida en Data Warehouse.

Inglés para trabajar en un entorno global.

Tecnologías y conocimientos clave:

Plataforma: Experiencia en data warehouses modernos como Snowflake, BigQuery o Redshift; on en data warehouses tradicionales como Oracle o Teradata.

Modelado de datos: Conocimiento de Kimball, Inmon o Data Vault 2.0.

Procesos dirigidos por metadatos.

Integración de datos: Herramientas modernas como dbt y dlt; o tradicionales como Talend, Informatica o similares.

Orquestación: Experiencia con Apache Airflow o Data Factory.

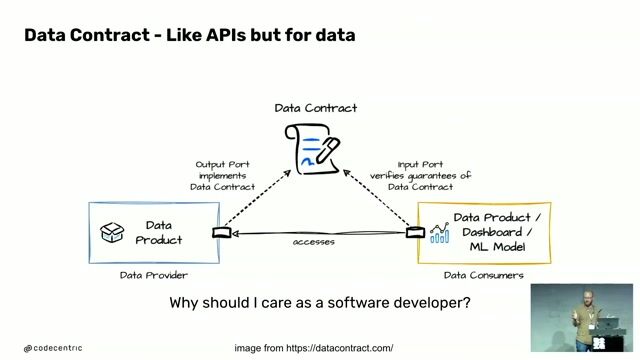

Gestión del código: Buenas prácticas y metodologías., Familiaridad con conceptos como DataOps, Data Observability y Data Mesh.

Experiencia en consultoría dentro del mundo Data & Analytics.

Formación extra como un Máster en Big Data & Analytics u otras certificaciones que potencien tus habilidades.

Conocimiento en tecnologías como Databricks, Microsoft Fabric, Glue, Dataflow o Dataproc.

Experiencia con contenedores y orquestación.

Cloud & Automatización: Infraestructura, pipelines de datos, operación y monitorización.